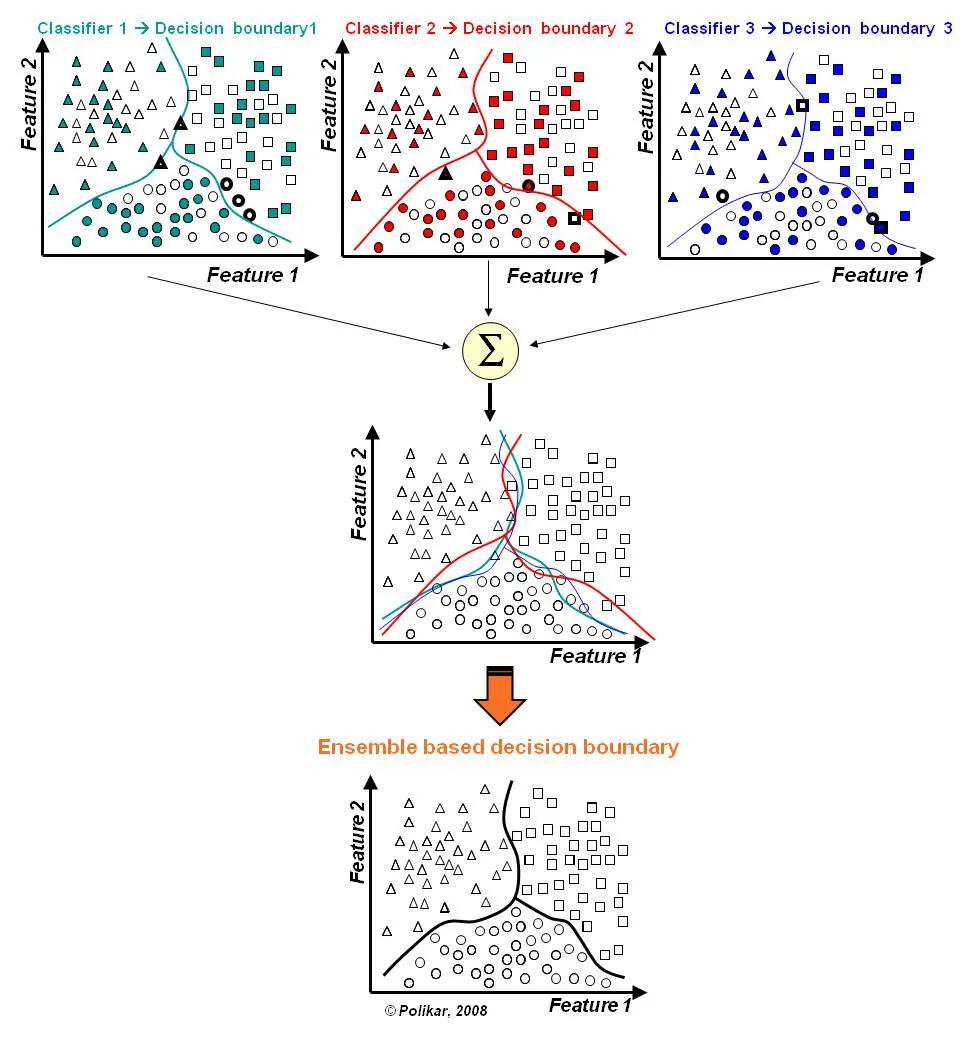

모델의 예측력 및 안정성을 높이기 위해 다수의 학습 알고리즘을 결합하여 학습을 수행하는 방법이다. @2022년 1월 17일

분류 문제를 위한 앙상블 학습 예 (scholarpedia.org)

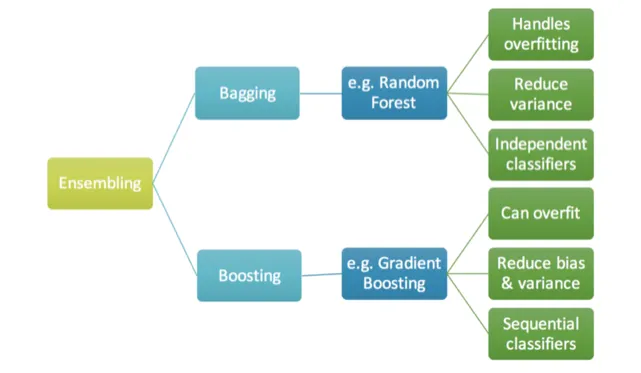

주요 앙상블 유형

앙상블 기법의 주요 계열로는 Bagging 과 Boosting 이 있으며, 각 계열 별 기법들의 장단점에 차이가 존재한다.

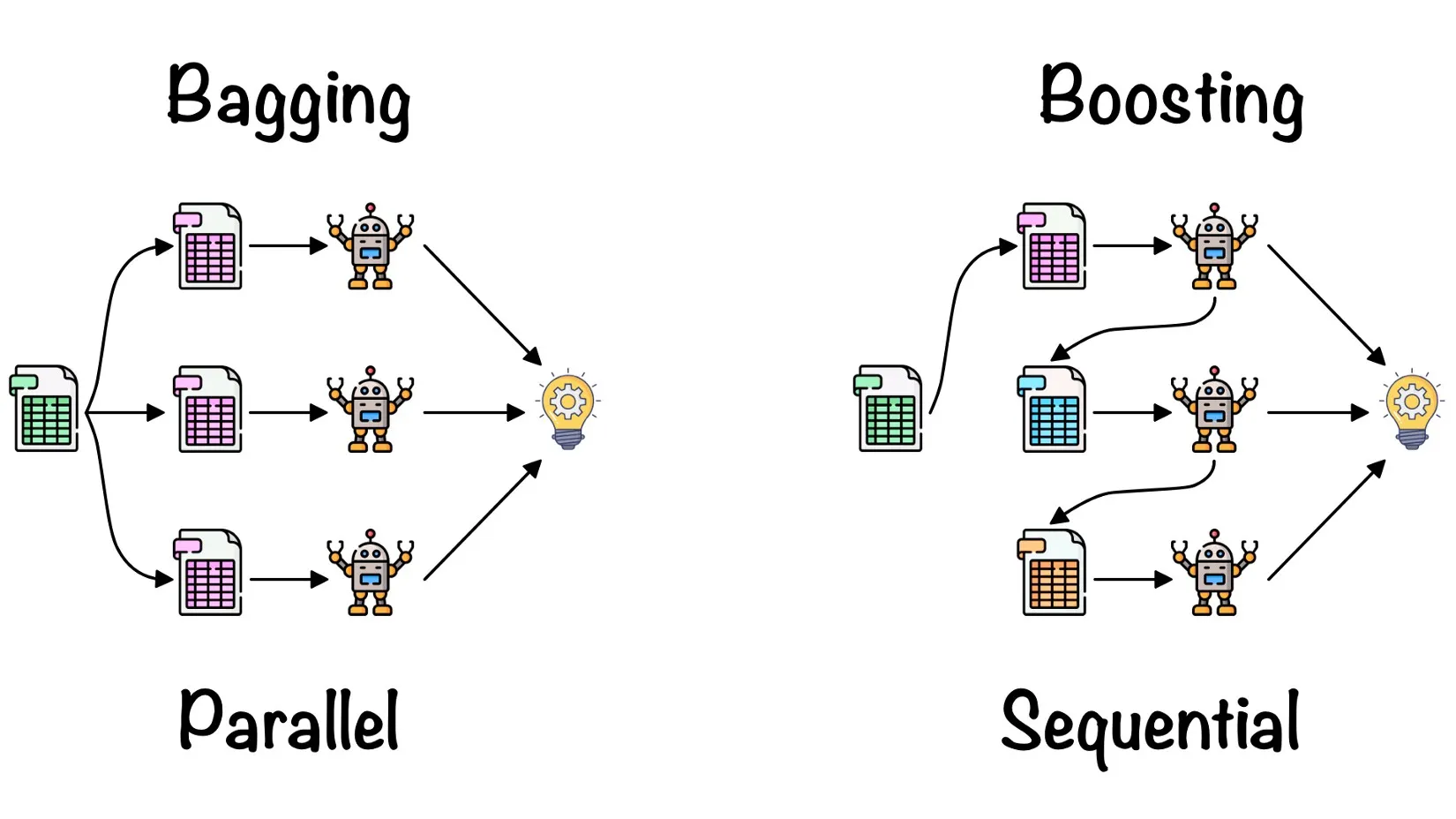

Bagging (bootstrap aggregating, 배깅)

Bootstrap을 통해 생성된 각각의 학습 데이터셋에 대해 모델을 생성하고, 이들의 개별 출력 결과를 결합(예: voting, averaging)하여 예측 값을 계산하는 앙상블 기법이다. 재표본화(resampling)를 통해 새롭게 생성된 학습 데이터셋을 사용하므로, 배깅을 통해 생성된 모델들은 서로 독립적이다.

Bootstrapping the data plus using the aggregate to make a decision is called “Bagging” - Bagging 의 어원

•

장점: 과적합 방지, 분산 감소

•

단점: 전략적 additive 방식인 부스팅에 비해 단순히 다수의 모델을 생성하고 출력을 합산하는 형태이므로, 성능이 비교적 낮음

•

대표 기법: Random Forest

Boosting (부스팅)

순차적으로 생성된 모델(week learner)들의 출력들을 결합하여 최종 예측 값을 계산하는 앙상블 기법이다. 모델과 학습 데이터셋들이 이전 단계의 부스팅 결과에 영향을 받으므로, 모든 모델들은 선행 모델 생성 결과에 의존성을 가진다(최초 모델 제외).

1.

무작위추출: 전체 데이터 → 샘플링된 데이터(부분집합)

2.

모든 데이터 샘플에 대한 가중치 초기화

3.

첫 번째 weak learner 학습 후 예측 결과(오차)에 따라 각 데이터 샘플에 대한 가중치()와 모델 가중치()를 계산

4.

데이터 샘플 가중치()를 통해 데이터를 갱신

5.

갱신된 데이터를 이용하여 두 번째 weak learner 학습.

6.

3~5 과정을 N번 반복

7.

N개의 weak learner 들의 가중치()를 통해 최종 모델을 생성

•

장점: 편향 및 분산 감소

•

단점: 과적합의 위험 존재

•

대표 기법: Gradient Boosting(예: XGBoost, LightGBM, Catboost)

Stacking (=stacked generalization, 스태킹)

모델들을 단계별로 구성하여 이전 단계의 모델들의 출력 값을 다음 단계의 모델 학습 과정에서 입력 값으로 사용하는 방식이다. 주로 두 단계로 구성된 앙상블 분류기를 학습할 때 사용된다.

참고문헌

1.

2.

.png&blockId=04a8d577-ace8-4bac-bec8-3da8a3f63bbd)